layerGraph

(권장되지 않음)딥러닝을 위한 신경망 계층의 그래프

설명

계층 그래프는 신경망의 아키텍처를 딥러닝 계층의 유방향 비순환 그래프(DAG)로 지정합니다. 계층은 여러 개의 입력값과 여러 개의 출력값을 가질 수 있습니다.

생성

설명

입력 인수

속성

객체 함수

addLayers | 신경망에 계층 추가하기 |

removeLayers | 신경망에서 계층 제거 |

replaceLayer | Replace layer in neural network |

connectLayers | 신경망에서 계층 연결하기 |

disconnectLayers | 신경망에서 계층 연결 끊기 |

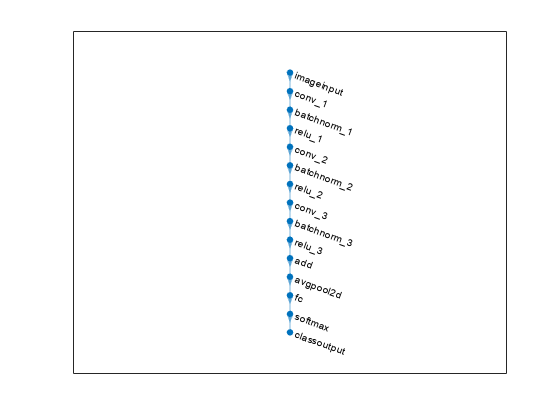

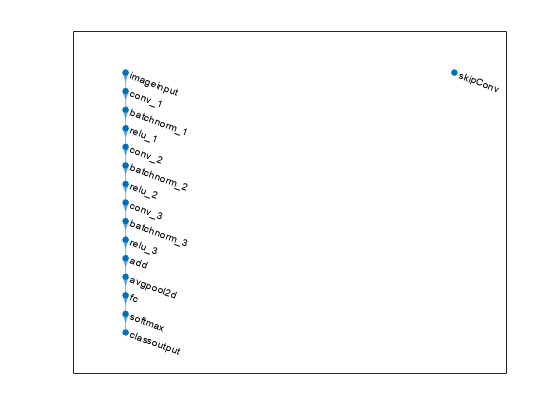

plot | 신경망 아키텍처 플로팅 |

예제

제한 사항

layer graph 객체에는 양자화 정보가 포함되지 않습니다. 양자화된 신경망에서 계층 그래프를 추출한 다음

assembleNetwork또는dlnetwork를 사용하여 신경망을 재조합하면 신경망에서 양자화 정보가 제거됩니다.