additionLayer

덧셈 계층

설명

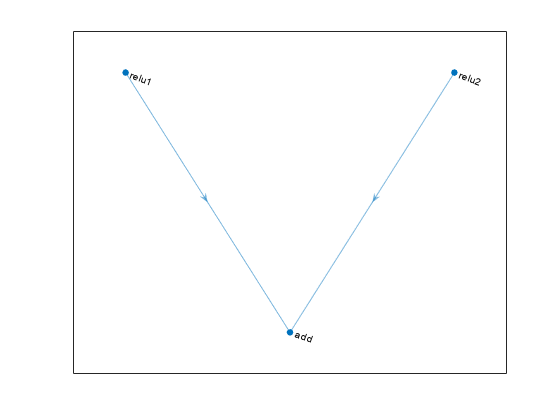

덧셈 계층은 여러 신경망 계층으로부터의 입력값을 요소별로 더합니다.

계층을 만들 때 계층의 입력값의 개수를 지정합니다. 계층의 입력값은 'in1','in2',...,'inN'과 같은 이름을 갖습니다. 여기서 N은 입력값의 개수입니다. 입력값 이름은 connectLayers 또는 disconnectLayers를 사용하여 계층을 연결하거나 연결을 끊을 때 사용합니다. 덧셈 계층의 입력값은 모두 동일한 차원을 가져야 합니다.