| 모든 알고리즘 |

Algorithm | 'trust-region-dogleg'(디폴트 값), 'trust-region', 'levenberg-marquardt' 중에서 선택합니다.

Algorithm 옵션은 사용할 알고리즘에 대한 기본 설정을 지정합니다. 이는 단지 기본적인 설정에 불과합니다. trust-region 알고리즘이라면 비선형 연립방정식이 부족 결정 시스템이어서는 안 됩니다. 다시 말해 방정식 개수(fun이 반환하는 F의 요소 개수)가 x의 길이보다 크거나 같아야 합니다. 마찬가지로 trust-region-dogleg 알고리즘이라면 방정식 개수가 x의 길이와 같아야 합니다. fsolve는 선택한 알고리즘을 사용할 수 없는 경우 Levenberg-Marquardt 알고리즘을 사용합니다. 알고리즘을 선택하는 방법에 대한 자세한 내용은 알고리즘 선택하기 항목을 참조하십시오.

optimoptions 대신 optimset을 사용하여 알고리즘 옵션을 설정하려면 다음과 같이 하십시오

Algorithm — 알고리즘을 'trust-region' 대신 'trust-region-reflective'로 설정합니다.

InitDamping — Algorithm을 셀형 배열(예: {'levenberg-marquardt',.005})로 설정하여 초기 Levenberg-Marquardt 파라미터 λ를 설정합니다.

|

| CheckGradients | 사용자 제공 도함수(목적 함수 또는 제약 조건의 기울기)를 유한 차분 도함수와 비교합니다. true 또는 false(디폴트 값)를 선택할 수 있습니다. optimset의 경우, 이 이름은 DerivativeCheck이고 값은 'on' 또는 'off'입니다. 현재 옵션 이름과 이전 옵션 이름 항목을 참조하십시오.

CheckGradients 옵션은 향후 릴리스에서 제거될 예정입니다. 도함수를 검사하려면 checkGradients 함수를 사용하십시오.

|

| Diagnostics | 최소화하거나 풀려는 함수에 대한 진단 정보를 표시합니다. 'on' 또는 'off'(디폴트 값)를 선택할 수 있습니다. |

| DiffMaxChange | 유한 차분 기울기에 대한 변수의 최대 변화량입니다(양의 스칼라). 디폴트 값은 Inf입니다. |

| DiffMinChange | 유한 차분 기울기에 대한 변수의 최소 변화량입니다(양의 스칼라). 디폴트 값은 0입니다. |

Display | 표시 수준입니다(반복 과정 표시 참조):

'off' 또는 'none'은 출력값을 표시하지 않습니다.

'iter'는 각 반복마다 출력값을 표시하고 디폴트 종료 메시지를 제공합니다.

'iter-detailed'는 각 반복마다 출력값을 표시하고 기술적인 종료 메시지를 제공합니다.

'final'(디폴트 값)은 최종 출력값만 표시하고 디폴트 종료 메시지를 제공합니다.

'final-detailed'는 최종 출력값만 표시하고 기술적인 종료 메시지를 제공합니다.

|

FiniteDifferenceStepSize | 유한 차분에 대한 스칼라 또는 벡터 스텝 크기 인자입니다. FiniteDifferenceStepSize를 벡터 v로 설정하는 경우 전향 유한 차분 delta는 다음과 같습니다. delta = v.*sign′(x).*max(abs(x),TypicalX);

sign′(x) = sign(x)입니다(단, sign′(0) = 1임). 중심 유한 차분은 다음과 같습니다.delta = v.*max(abs(x),TypicalX);

FiniteDifferenceStepSize는 벡터로 확장됩니다. 디폴트 값은 전향 유한 차분의 경우 sqrt(eps)이고 중심 유한 차분의 경우 eps^(1/3)입니다. optimset의 경우, 이 이름은 FinDiffRelStep입니다. 현재 옵션 이름과 이전 옵션 이름 항목을 참조하십시오.

|

FiniteDifferenceType | 기울기를 추정하는 데 사용되는 유한 차분으로, 'forward'(디폴트 값) 또는 'central'(중심화됨)입니다. 'central'은 함수 실행 횟수가 2배 더 많지만 더 정확합니다. 알고리즘은 두 유형의 유한 차분을 모두 추정하는 경우 범위를 준수하려고 노력합니다. 예를 들어, 범위 외부에 있는 점에서 실행되는 것을 방지하기 위해 전향 차분이 아니라 후향 차분을 사용할 수 있습니다. optimset의 경우, 이 이름은 FinDiffType입니다. 현재 옵션 이름과 이전 옵션 이름 항목을 참조하십시오.

|

FunctionTolerance | 함수 값에 대한 종료 허용오차로, 음이 아닌 스칼라입니다. 디폴트 값은 1e-6입니다. 허용오차와 중지 기준 항목을 참조하십시오. optimset의 경우, 이 이름은 TolFun입니다. 현재 옵션 이름과 이전 옵션 이름 항목을 참조하십시오.

|

| FunValCheck | 목적 함수 값이 유효한지 여부를 확인합니다. 'on'은 목적 함수가 complex, Inf 또는 NaN 값을 반환하는 경우에 오류를 표시합니다. 디폴트 값인 'off'는 오류를 표시하지 않습니다. |

MaxFunctionEvaluations | 허용되는 함수 실행의 최대 횟수로, 음이 아닌 정수입니다. 디폴트 값은 'trust-region-dogleg' 알고리즘과 'trust-region' 알고리즘의 경우 100*numberOfVariables이고, 'levenberg-marquardt' 알고리즘의 경우 200*numberOfVariables입니다. 허용오차와 중지 기준 항목과 반복 횟수와 함수 실행 횟수 항목을 참조하십시오. optimset의 경우, 이 이름은 MaxFunEvals입니다. 현재 옵션 이름과 이전 옵션 이름 항목을 참조하십시오.

|

MaxIterations | 허용되는 최대 반복 횟수로, 음이 아닌 정수입니다. 디폴트 값은 400입니다. 허용오차와 중지 기준 항목과 반복 횟수와 함수 실행 횟수 항목을 참조하십시오. optimset의 경우, 이 이름은 MaxIter입니다. 현재 옵션 이름과 이전 옵션 이름 항목을 참조하십시오.

|

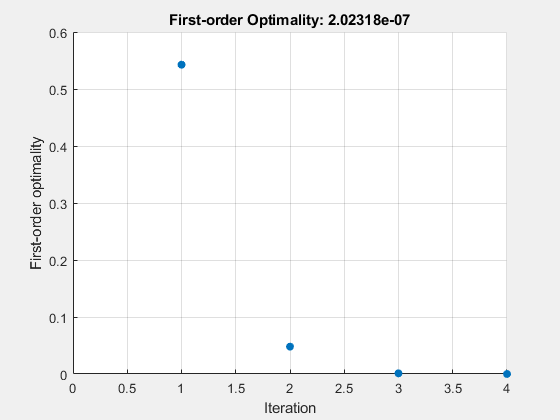

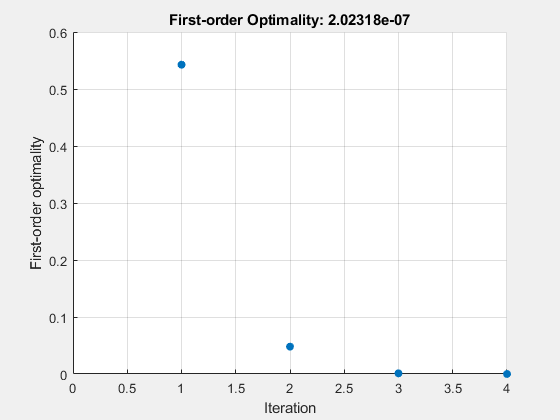

OptimalityTolerance | 1차 최적성에 대한 종료 허용오차(음이 아닌 스칼라)입니다. 디폴트 값은 1e-6입니다. 1차 최적성 측정값 항목을 참조하십시오. 내부적으로, 'levenberg-marquardt' 알고리즘은 최적성 허용오차(중지 기준) 1e-4와 FunctionTolerance를 곱한 값을 사용하고 OptimalityTolerance는 사용하지 않습니다. |

OutputFcn | 각 반복마다 최적화 함수가 호출하는 하나 이상의 사용자 정의 함수를 지정합니다. 함수 핸들 또는 함수 핸들 셀형 배열을 전달합니다. 디폴트 값은 없음([])입니다. Output Function and Plot Function Syntax 항목을 참조하십시오. |

PlotFcn | 알고리즘이 실행되는 동안 다양한 진행률 측정값을 플로팅합니다. 미리 정의된 플롯에서 선택하거나 사용자가 직접 작성할 수 있습니다. 내장 플롯 함수 이름, 함수 핸들 또는 내장 플롯 함수 이름이나 함수 핸들로 구성된 셀형 배열을 전달하십시오. 사용자 지정 플롯 함수의 경우, 함수 핸들을 전달하십시오. 디폴트 값은 없음([])입니다.

'optimplotx'는 현재 점을 플로팅합니다.

'optimplotfunccount'는 함수 실행 횟수를 플로팅합니다.

'optimplotfval'은 함수 값을 플로팅합니다.

'optimplotstepsize'는 스텝 크기를 플로팅합니다.

'optimplotfirstorderopt'는 1차 최적성 측정값을 플로팅합니다.

사용자 지정 플롯 함수는 출력 함수와 동일한 구문을 사용합니다. Optimization Toolbox의 출력 함수 항목과 Output Function and Plot Function Syntax 항목을 참조하십시오. optimset의 경우, 이 이름은 PlotFcns입니다. 현재 옵션 이름과 이전 옵션 이름 항목을 참조하십시오.

|

SpecifyObjectiveGradient | true인 경우, fsolve는 목적 함수에 대해 사용자 정의 야코비 행렬(fun에서 정의됨) 또는 야코비 행렬 정보(JacobianMultiplyFcn을 사용하는 경우)를 사용합니다. false(디폴트 값)인 경우, fsolve는 유한 차분을 사용하여 야코비 행렬의 근삿값을 계산합니다.

optimset의 경우, 이 이름은 Jacobian이고 값은 'on' 또는 'off'입니다. 현재 옵션 이름과 이전 옵션 이름 항목을 참조하십시오.

|

StepTolerance | x에 대한 종료 허용오차로, 음이 아닌 스칼라입니다. 디폴트 값은 1e-6입니다. 허용오차와 중지 기준 항목을 참조하십시오.

optimset의 경우, 이 이름은 TolX입니다. 현재 옵션 이름과 이전 옵션 이름 항목을 참조하십시오.

|

TypicalX | 일반적인 x 값입니다. TypicalX의 요소 개수는 시작점 x0의 요소 개수와 같습니다. 디폴트 값은 ones(numberofvariables,1)입니다. fsolve는 기울기 추정을 위해 유한 차분을 스케일링하는 데 TypicalX를 사용합니다. trust-region-dogleg 알고리즘은 스케일링 행렬의 대각 항으로 TypicalX를 사용합니다.

|

UseParallel | true인 경우 fsolve는 기울기를 병렬로 추정합니다. 디폴트 값 false로 설정하면 비활성화됩니다. 병렬 연산 항목을 참조하십시오.

|

| trust-region 알고리즘 |

JacobianMultiplyFcn | 야코비 행렬의 곱셈 함수로, 함수 핸들로 지정됩니다. 특정 구조를 가진 대규모 문제의 경우, 이 함수는 J를 실제로 구성하지 않고 야코비 행렬 곱 J*Y, J'*Y 또는 J'*(J*Y)를 계산합니다. 이 함수의 형식은 다음과 같습니다. 여기서 Jinfo는 J*Y(또는 J'*Y나 J'*(J*Y))를 계산하는 데 사용되는 데이터를 포함합니다. 첫 번째 인수 Jinfo는 목적 함수 fun이 반환하는 두 번째 인수입니다. 예를 들어 다음과 같습니다. Y는 문제의 차원과 동일한 개수의 행을 갖는 행렬입니다. flag는 계산해야 하는 곱을 결정합니다.

어느 경우든 J가 명시적으로 구성되지는 않습니다. fsolve는 Jinfo를 사용하여 선조건자를 계산합니다. jmfun에 필요한 추가 파라미터의 값을 제공하는 방법에 대한 자세한 내용은 추가 파라미터 전달하기 항목을 참조하십시오. 참고 fsolve가 fun에서 jmfun으로 Jinfo를 전달하도록 하려면 'SpecifyObjectiveGradient'가 true로 설정되어야 합니다.

유사한 예제는 Minimization with Dense Structured Hessian, Linear Equalities 항목을 참조하십시오. optimset의 경우, 이 이름은 JacobMult입니다. 현재 옵션 이름과 이전 옵션 이름 항목을 참조하십시오.

|

| JacobPattern | 유한 차분을 위한 야코비 행렬의 희소성 패턴입니다. fun(i)가 x(j)에 종속되는 경우 JacobPattern(i,j) = 1을 설정합니다. 그렇지 않은 경우 JacobPattern(i,j) = 0을 설정합니다. 다시 말해, ∂fun(i)/∂x(j) ≠ 0이 성립하는 경우 JacobPattern(i,j) = 1을 설정합니다. JacobPattern은 fun의 야코비 행렬 J를 계산하는 것이 번거롭고 fun(i)가 x(j)에 종속된다는 사실은 (조사를 통해) 확인할 수 있는 경우에 사용합니다. JacobPattern을 제공하는 경우 fsolve는 희소 유한 차분을 통해 J의 근삿값을 계산할 수 있습니다.

최악의 경우, 구조를 알 수 없다면 JacobPattern을 설정하지 마십시오. 이 경우 기본적으로 JacobPattern이 1로 구성된 조밀 행렬인 것처럼 동작합니다. 그러면 fsolve가 각 반복마다 비희소 유한 차분 근삿값을 계산합니다. 이 과정은 대규모 문제의 경우 시간이 아주 오래 걸릴 수 있으므로 희소성 구조를 확인하는 것이 일반적으로 더 좋습니다. |

| MaxPCGIter | 최대 PCG(선조건 적용 켤레 기울기) 반복 횟수로, 양의 스칼라입니다. 디폴트 값은 max(1,floor(numberOfVariables/2))입니다. 자세한 내용은 방정식 풀이 알고리즘 항목을 참조하십시오. |

| PrecondBandWidth | PCG에 대한 선조건자의 상부 대역폭으로, 음이 아닌 정수입니다. 디폴트 값 PrecondBandWidth는 Inf이며, 이는 직접 분해(촐레스키)가 켤레 기울기(CG) 대신 사용된다는 것을 의미합니다. 직접 분해는 CG보다 계산량이 더 많지만 해에 다가가는 데 있어 더 나은 품질의 스텝을 생성합니다. 대각 선조건 지정에서는 PrecondBandWidth를 0으로 설정합니다(상부 대역폭: 0). 일부 문제의 경우, 중간 대역폭을 사용하면 PCG 반복 횟수가 줄어듭니다. |

SubproblemAlgorithm | 반복 스텝이 계산되는 방식을 결정합니다. 디폴트 값 'factorization'은 'cg'보다 더 느리지만 더 정확한 스텝을 실행합니다. Trust-Region 알고리즘 항목을 참조하십시오. |

| TolPCG | PCG 반복에 대한 종료 허용오차로, 양의 스칼라입니다. 디폴트 값은 0.1입니다. |

| Levenberg-Marquardt 알고리즘 |

| InitDamping | Levenberg-Marquardt 파라미터의 초기값으로, 양의 스칼라입니다. 디폴트 값은 1e-2입니다. 자세한 내용은 Levenberg-Marquardt 방법 항목을 참조하십시오. |

| ScaleProblem | 'jacobian'을 사용하면 잘못 스케일링된 문제의 수렴이 향상될 수도 있습니다. 디폴트 값은 'none'입니다.

|