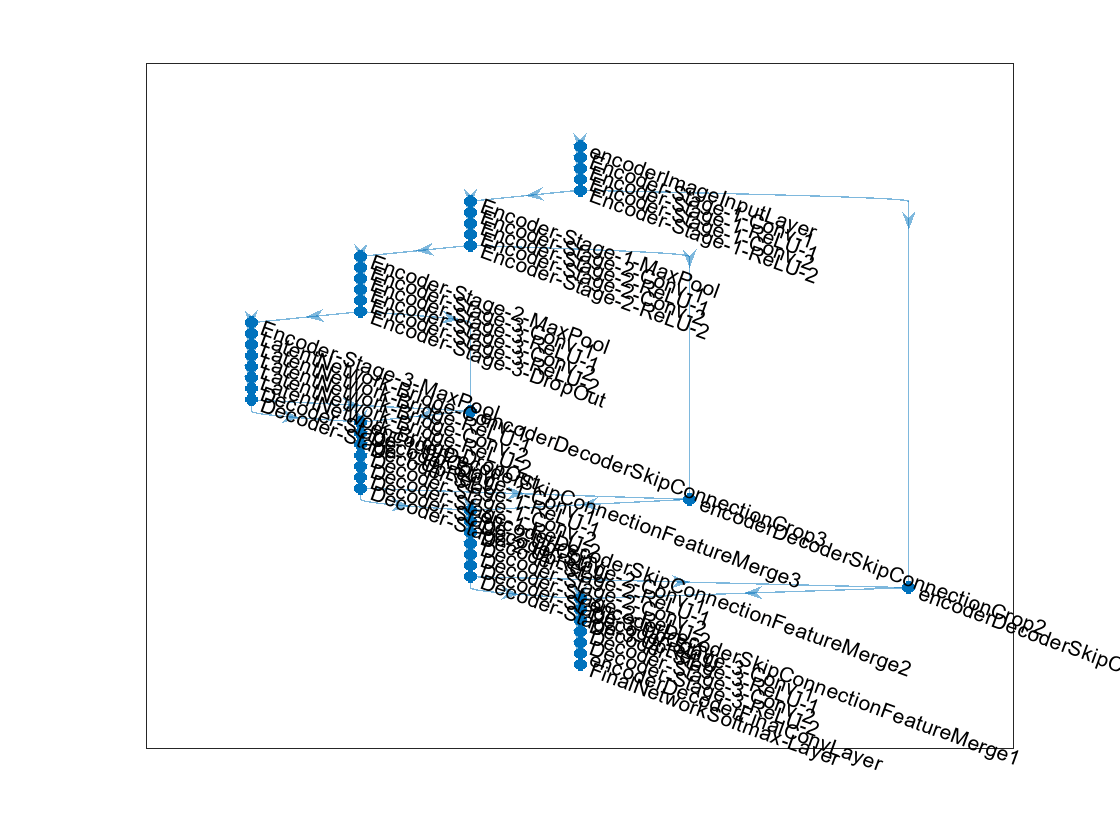

unet

구문

설명

unetNetwork = unet(imageSize,numClasses)

unet을 사용하여 U-Net 신경망 아키텍처를 만듭니다. Deep Learning Toolbox™ 함수 trainnet (Deep Learning Toolbox)을 사용하여 신경망을 훈련시켜야 합니다.

[는 U-Net 신경망의 출력 크기도 반환합니다.unetNetwork,outputSize] = unet(imageSize,numClasses)

___ = unet(는 하나 이상의 이름-값 인수를 사용하여 옵션을 지정합니다. 예를 들어, imageSize,numClasses,Name=Value)unet(imageSize,numClasses,NumFirstEncoderFilters=64)는 첫 번째 인코더 단계의 출력 채널 개수를 64로 지정합니다.

예제

입력 인수

이름-값 인수

출력 인수

세부 정보

팁

컨벌루션 계층에서

'same'채우기를 사용하면 입력에서 출력까지 동일한 데이터 크기를 유지하고 다양한 입력 영상 크기를 사용할 수 있습니다.패치 기반 접근 방식을 사용하면 큰 영상을 원활하게 분할할 수 있습니다.

randomPatchExtractionDatastore함수를 사용하여 영상 패치를 추출할 수 있습니다.'valid'채우기를 사용하면 패치 기반 접근 방식을 사용하여 분할하는 동안 경계 아티팩트를 방지할 수 있습니다.trainnet(Deep Learning Toolbox)으로 훈련한 후unet함수를 사용하여 생성된 신경망을 GPU 코드 생성에 사용할 수 있습니다. 자세한 내용과 예제는 코드 생성 및 심층 신경망 배포하기 (Deep Learning Toolbox) 항목을 참조하십시오.

참고 문헌

[1] Ronneberger, O., P. Fischer, and T. Brox. "U-Net: Convolutional Networks for Biomedical Image Segmentation." Medical Image Computing and Computer-Assisted Intervention (MICCAI). Vol. 9351, 2015, pp. 234–241.

[2] He, K., X. Zhang, S. Ren, and J. Sun. "Delving Deep Into Rectifiers: Surpassing Human-Level Performance on ImageNet Classification." Proceedings of the IEEE International Conference on Computer Vision. 2015, 1026–1034.

확장 기능

버전 내역

R2024a에 개발됨

참고 항목

객체

dlnetwork(Deep Learning Toolbox)

함수

trainnet(Deep Learning Toolbox) |deeplabv3plus|unet3d|pretrainedEncoderNetwork|semanticseg|evaluateSemanticSegmentation

도움말 항목

- 딥러닝을 사용한 다중분광 영상의 의미론적 분할

- 딥러닝을 사용한 의미론적 분할 시작하기

- MATLAB의 딥러닝 (Deep Learning Toolbox)